¿Qué tan compleja es desde el punto de vista computacional una sola neurona?

NUESTROS CEREBROS BLANDOS parece muy lejos de los chips de silicio sólido en los procesadores de computadora, pero los científicos tienen una larga historia de comparar los dos. Como dijo Alan Turing en 1952: “No nos interesa el hecho de que el cerebro tenga la consistencia de una papilla fría”. En otras palabras, no importa el medio, solo la capacidad computacional.

Hoy en día, los sistemas de inteligencia artificial más poderosos emplean un tipo de aprendizaje automático llamado aprendizaje profundo. Sus algoritmos aprenden procesando cantidades masivas de datos a través de capas ocultas de nodos interconectados, conocidas como redes neuronales profundas. Como sugiere su nombre, las redes neuronales profundas se inspiraron en las redes neuronales reales del cerebro, con los nodos modelados a partir de neuronas reales o, al menos, a partir de lo que los neurocientíficos sabían sobre las neuronas en la década de 1950, cuando un influyente modelo de neuronas llamado el perceptron nació. Desde entonces, nuestra comprensión de la complejidad computacional de las neuronas individuales se ha expandido drásticamente, por lo que se sabe que las neuronas biológicas son más complejas que las artificiales. ¿Pero por cuánto?

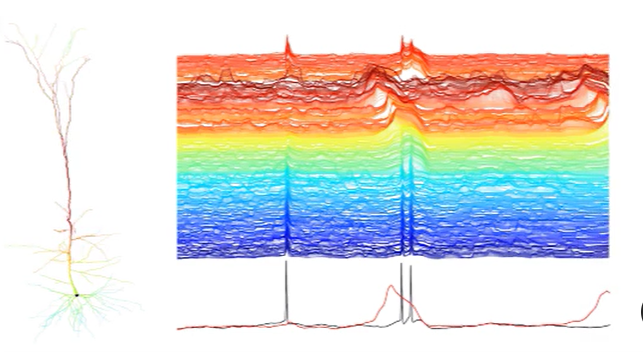

Para averiguarlo, David Beniaguev , Idan Segev y Michael London , todos en la Universidad Hebrea de Jerusalén, entrenaron una red neuronal profunda artificial para imitar los cálculos de una neurona biológica simulada. Ellos mostraron que una red neuronal profunda requiere entre cinco y ocho capas de neuronas interconectadas “” para representar la complejidad de una neurona biológica única.

Incluso los autores no anticiparon tal complejidad. “Pensé que sería más simple y más pequeño”, dijo Beniaguev. Esperaba que tres o cuatro capas fueran suficientes para capturar los cálculos realizados dentro de la celda.

Timothy Lillicrap , que diseña algoritmos de toma de decisiones en la empresa de inteligencia artificial DeepMind, propiedad de Google, dijo que el nuevo resultado sugiere que podría ser necesario repensar la vieja tradición de comparar libremente una neurona en el cerebro con una neurona en el contexto del aprendizaje automático. “Este documento realmente ayuda a forzar el tema de pensar en eso con más cuidado y lidiar con hasta qué punto se pueden hacer esas analogías”, dijo.

La analogía más básica entre neuronas artificiales y reales implica cómo manejan la información entrante. Ambos tipos de neuronas reciben señales entrantes y, basándose en esa información, deciden si envían su propia señal a otras neuronas. Si bien las neuronas artificiales se basan en un cálculo simple para tomar esta decisión, décadas de investigación han demostrado que el proceso es mucho más complicado en las neuronas biológicas. Los neurocientíficos computacionales utilizan una función de entrada-salida para modelar la relación entre las entradas recibidas por las ramas largas en forma de árbol de una neurona biológica, llamadas dendritas, y la decisión de la neurona de enviar una señal.

Esta función es la que los autores del nuevo trabajo le enseñaron a imitar a una red neuronal profunda artificial para determinar su complejidad. Comenzaron creando una simulación masiva de la función de entrada y salida de un tipo de neurona con distintos árboles de ramas dendríticas en su parte superior e inferior, conocida como neurona piramidal, de la corteza de una rata. Luego, introdujeron la simulación en una red neuronal profunda que tenía hasta 256 neuronas artificiales en cada capa. Continuaron aumentando el número de capas hasta que lograron una precisión del 99 por ciento en el nivel de milisegundos entre la entrada y la salida de la neurona simulada. La red neuronal profunda predijo con éxito el comportamiento de la función de entrada-salida de la neurona con al menos cinco, pero no más de ocho, capas artificiales. En la mayoría de las redes, eso equivalía a aproximadamente 1

“[El resultado] forma un puente entre las neuronas biológicas y las neuronas artificiales”, dijo Andreas Tolias , neurocientífico computacional de Baylor College of Medicine.

Pero los autores del estudio advierten que aún no se trata de una correspondencia sencilla. “La relación entre cuántas capas tiene en una red neuronal y la complejidad de la red no es obvia”, dijo London. Por lo tanto, realmente no podemos decir cuánta más complejidad se gana al pasar de, digamos, cuatro capas a cinco. Tampoco podemos decir que la necesidad de 1.000 neuronas artificiales signifique que una neurona biológica sea exactamente 1.000 veces más compleja. En última instancia, es posible que el uso de neuronas artificiales exponencialmente más dentro de cada capa eventualmente conduzca a una red neuronal profunda con una sola capa, pero probablemente requeriría muchos más datos y tiempo para que el algoritmo aprenda.

“Probamos muchas, muchas arquitecturas con muchas profundidades y muchas cosas, y la mayoría fracasamos”, dijo London. Los autores han compartido su código para animar a otros investigadores a encontrar una solución inteligente con menos capas. Pero, dado lo difícil que fue encontrar una red neuronal profunda que pudiera imitar la neurona con una precisión del 99 por ciento, los autores confían en que su resultado proporciona una comparación significativa para futuras investigaciones. Lillicrap sugirió que podría ofrecer una nueva forma de relacionar las redes de clasificación de imágenes, que a menudo requieren más de 50 capas, con el cerebro. Si cada neurona biológica es como una red neuronal artificial de cinco capas, entonces quizás una red de clasificación de imágenes con 50 capas sea equivalente a 10 neuronas reales en una red biológica.

Los autores también esperan que su resultado cambie la arquitectura de red profunda de vanguardia actual en IA. “Pedimos el reemplazo de la tecnología de red profunda para acercarla a cómo funciona el cerebro al reemplazar cada unidad simple en la red profunda hoy con una unidad que representa una neurona, que ya es, por sí misma, profunda”, dijo Segev. En este escenario de reemplazo, los investigadores e ingenieros de IA podrían conectar una red profunda de cinco capas como una “mini red” para reemplazar todas las neuronas artificiales.

Pero algunos se preguntan si esto realmente beneficiaría a la IA. “Creo que es una pregunta abierta, si existe una ventaja computacional real”, dijo Anthony Zador , neurocientífico del Laboratorio Cold Spring Harbor. “Este trabajo sienta las bases para probar eso”.

Fuera de las aplicaciones de inteligencia artificial, el nuevo artículo también se suma a un consenso creciente sobre el fuerte poder computacional de los árboles dendríticos y, por proxy, las neuronas individuales. En 2003 , un trío de neurocientíficos demostró que los árboles dendríticos de una neurona piramidal realizan cálculos complejos modelándola como una red neuronal artificial de dos capas. En el nuevo artículo, los autores investigaron qué características de la neurona piramidal inspiraron una complejidad mucho mayor en sus redes neuronales profundas de cinco a ocho capas. Concluyeron que provenía de los árboles dendríticos y de un receptor específico que recibe mensajeros químicos en la superficie de las dendritas, hallazgos que coincidían con trabajos previos en el campo.

Algunos creen que el resultado significa que los neurocientíficos deberían dar mayor prioridad al estudio de neuronas individuales. “Este artículo hace que pensar en las dendritas y las neuronas individuales sea mucho más importante que antes”, dijo Konrad Kording , neurocientífico computacional de la Universidad de Pensilvania. Otros, como Lillicrap y Zador, sugirieron que centrarse en las neuronas dentro de un circuito será tan importante para aprender cómo el cerebro realmente utiliza la complejidad computacional de las neuronas individuales.

Independientemente, el lenguaje de las redes neuronales artificiales puede proporcionar una nueva comprensión del poder de las neuronas y, en última instancia, del cerebro. “Pensar en términos de capas, profundidades y anchos nos da una sensación intuitiva de complejidad computacional”, dijo Grace Lindsay , neurocientífica computacional del University College London. Sin embargo, Lindsay también advierte que el nuevo trabajo solo compara un modelo con un modelo. Desafortunadamente, actualmente es imposible para los neurocientíficos registrar la función de entrada y salida completa de una neurona real, por lo que es probable que estén sucediendo más cosas que el modelo de una neurona biológica no está capturando. En otras palabras, las neuronas reales podrían ser incluso más complejas.

“No estamos seguros de que entre cinco y ocho sea realmente el número final”, dijo London.